metaio가 열심히 홍보하던 Junaio가 11일자로 앱 스토어에 등록되어 모습을 공개하였습니다. 그동안 Layar의 SPRXMobile이나 Wikitude의 Mobilizy와 같은 신생 회사들이 모바일 AR 시장에 출사표를 던지며 인기를 몰고 있었습니다만, 기존의 전통 AR 회사들이 상대적으로 조용했던 것도 사실입니다. 최근에야 Total Immersion이 모바일 AR 게임 분야에 진출하기 위해 int13과 협력하기로 했다는 소식이 전해졌었죠. 한편, metaio 역시 이에 질세라 수많은 회사들이 각축을 벌이는 AR 브라우저 시장에 뛰어든다는 계획을 두달 전에 발표하였고, 그 결실이 바로 Junaio입니다.

처음에는 알 수 없는 티져 영상으로 관심을 끌더니 막바지에 이르러 드러낸 실체는 아래와 같았습니다. GPS와 나침반 기반의, 요즘 흔히 보이는 소위 짝퉁 AR (pseudo-AR)의 일종이라고 할 수 있겠습니다.

그럼 차이점은 무엇일까요? 일단 사진과 글 위주의 2D 정보를 제공하는 다른 서비스들과는 다르게 3D 콘텐츠의 제공에 초점을 맞추고 있습니다. Layar가 한발 앞서 3D 지원을 공표하였습니다만, 아직 구체화되지는 않았죠. 이 틈을 비집고 들어온 Junaio는 사용자의 카메라 사진을 3D 모델로 ‘증강’하여 UCC를 제작하고 공유하는 서비스를 표방하게 됩니다.

물론 논란의 여지는 있습니다. 이러한 사진 증강은 사용자가 3D 모델을 직접 돌려가며 수고한 결과입니다. 마치 스티커 사진을 찍고 나서 일일이 배경을 설정해주어야 하는 포토제닉과 같은 과정이죠. 대개 증강현실에서는 이러한 정합(registration)의 자동 수행을 기대합니다만, Junaio에서는 유사한 느낌을 수동적으로 표현해주는 것에 그치고 있습니다. 물론 이렇게 만들어진 콘텐츠는 Wikitude처럼 카메라 영상 위에 둥둥 떠다니는 아이콘으로 네비게이션 할 수 있으니 여전히 광의의 AR 범주에는 포함되겠습니다만, 3D 모델이 카메라 영상 위에서 실시간으로 정합되는 증강현실 기술을 기대하였다면 실망이겠죠.

대신 Junaio는 사진을 꾸미고 돌려보는 재미 그 자체에 초점을 맞추었습니다. 오히려 이 점이 여타 AR 브라우저들과 차별화되는 부분이기도 합니다. 증강현실이라는 마케팅 트렌드 속에서 탄생한 “위치 기반 소셜 포토제닉 서비스”인 셈이죠.

사실 사진과 3D 모델의 합성 쪽에서는 3DVIA Mobile이라는 앱이 이미 출시되어 있긴 합니다. 그렇지만 차이점이라면 3DVIA Mobile이 모델러가 디자인한 3D 모델의 공유에 초점을 맞추는 반면, Junaio는 이러한 모델로 가공된 콘텐츠의 공유에 더 많은 신경을 쓰고 있다는 것입니다. 이를 위해 위치 기반 서비스가 된 것이고, 위키처럼 다른 사람의 콘텐츠를 마음대로 수정할 수 있는 것이며, 웹에서 접근 가능한 지도 서비스가 별도 제공되는 것이겠지요. Junaio의 시도가 UCC 산업에 새로운 바람을 일으킬 수 있을지 기대해봅니다.

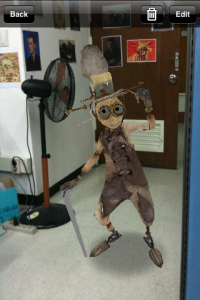

아래는 처음 만들어본 짤방입니다^^;