Wikitude와 Layar가 경쟁적으로 개발자용 API의 공개를 선언한 가운데, Wikitude에서는 사용자들이 새로운 콘텐츠를 손쉽게 입력할 수 있는 서비스를 시작하였습니다.

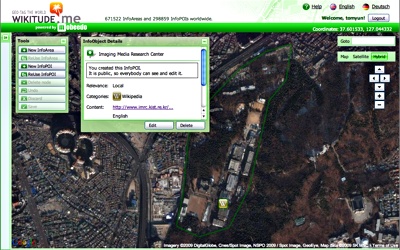

WIKITUDE.me에서 서울 어딘가의 POI를 설정하고 있는 화면

이름은 WIKITUDE.me입니다. 왠지 MobileMe를 떠올리게 하는군요. Google Maps 기반의 지도 위에서 원하는 영역 혹은 지점을 정의한 다음, 적절한 분류를 선택하고 외부 자료와의 링크도 설정할 수 있습니다. 위키라는 이름처럼 다른 사용자가 입력한 자료 또한 마음대로 수정할 수 있기 때문에 정보의 지속적인 갱신도 기대해볼 수 있겠죠. 이렇게 입력된 자료가 실제 Android상에서 잘 보이는지는 아직 확인 못 해봤습니다:)

어떤 서비스가 되었든 그 성공의 열쇠는 콘텐츠라는 사실이 자명합니다. 앞으로 얼마나 많은 사용자들을 끌어들여 자발적인 콘텐츠의 생산을 유도할 것인가가 관건이 되겠죠. 남들보다 한발 앞서 아이디어를 시험해보고 싶으신 분들은 지금 바로 각 서비스의 API 테스터 모집에 지원해 보기 바랍니다. Wikitude는 이곳, Layar는 이곳에서 할 수 있습니다.